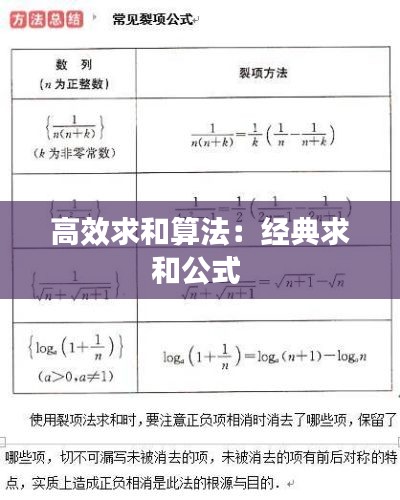

引言

在计算机科学和数据处理的领域中,求和是一个基础且频繁的操作。无论是简单的数值累加,还是复杂的数据分析,求和都是不可或缺的步骤。然而,随着数据量的增加,传统的求和算法可能会变得效率低下。因此,研究高效求和算法对于提高程序性能具有重要意义。

传统求和算法

最简单的求和算法是逐个元素累加。这种方法的时间复杂度为O(n),其中n是待求和元素的个数。对于小规模数据,这种方法可能足够高效。但是,当数据量增大时,逐个元素累加的时间开销会显著增加。

def sum_elements(elements):

total = 0

for element in elements:

total += element

return total分治法求和

分治法是一种常用的算法设计思想,它将大问题分解为小问题,递归解决小问题,然后合并结果。在求和操作中,我们可以将数据集分成两部分,分别对这两部分进行求和,然后将结果相加。这种方法的时间复杂度为O(nlogn),因为它需要将数据集分成logn层,每层处理n个元素。

def divide_and_conquer_sum(elements):

if len(elements) == 1:

return elements[0]

mid = len(elements) // 2

left_sum = divide_and_conquer_sum(elements[:mid])

right_sum = divide_and_conquer_sum(elements[mid:])

return left_sum + right_sum并行求和算法

随着多核处理器的普及,并行计算成为提高计算效率的重要手段。并行求和算法可以将数据集分割成多个子集,每个子集由不同的线程或进程处理,最后将结果合并。这种方法的时间复杂度可以降低到O(n/p),其中p是并行处理的线程或进程数。

from multiprocessing import Pool

def parallel_sum(elements, num_processes):

if len(elements) == 1:

return elements[0]

mid = len(elements) // 2

pool = Pool(processes=num_processes)

left_sum = pool.apply_async(divide_and_conquer_sum, (elements[:mid],))

right_sum = pool.apply_async(divide_and_conquer_sum, (elements[mid:],))

pool.close()

pool.join()

return left_sum.get() + right_sum.get()

# Example usage

if __name__ == '__main__':

elements = range(1000000)

num_processes = 4

print(parallel_sum(elements, num_processes))哈希表求和

当求和操作涉及到多个数据集时,可以使用哈希表来提高效率。哈希表可以将多个数据集映射到一个共同的键空间,然后对每个键对应的值进行累加。这种方法的时间复杂度取决于哈希函数的设计和数据分布,但通常可以达到O(n)。

def hash_table_sum(data):

hash_table = {}

for key, value in data.items():

if key in hash_table:

hash_table[key] += value

else:

hash_table[key] = value

return sum(hash_table.values())

# Example usage

data = {'a': 10, 'b': 20, 'c': 30}

print(hash_table_sum(data))总结

高效求和算法是提高数据处理效率的关键。从简单的逐个元素累加到复杂的并行计算,不同的算法适用于不同的场景和数据规模。选择合适的求和算法,可以显著提升程序的执行速度,特别是在处理大规模数据时。

在实际应用中,我们需要根据具体问题选择最合适的求和算法。对于小规模数据,逐个元素累加可能已经足够高效。对于大规模数据,分治法、并行计算或哈希表等方法可能更加适用。通过不断优化和选择合适的算法,我们可以实现高效的求和操作,从而提高整个程序的效率。

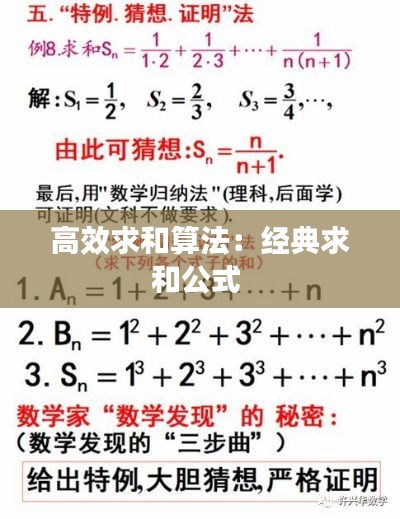

转载请注明来自北京贝贝鲜花礼品网,本文标题:《高效求和算法:经典求和公式 》

蜀ICP备2022005971号-1

蜀ICP备2022005971号-1

还没有评论,来说两句吧...